30秒通过OpenAI格式接口与Gemini Pro对话

① 获得接口链接

新建 Colab 笔记:

把以下内容粘贴进去:

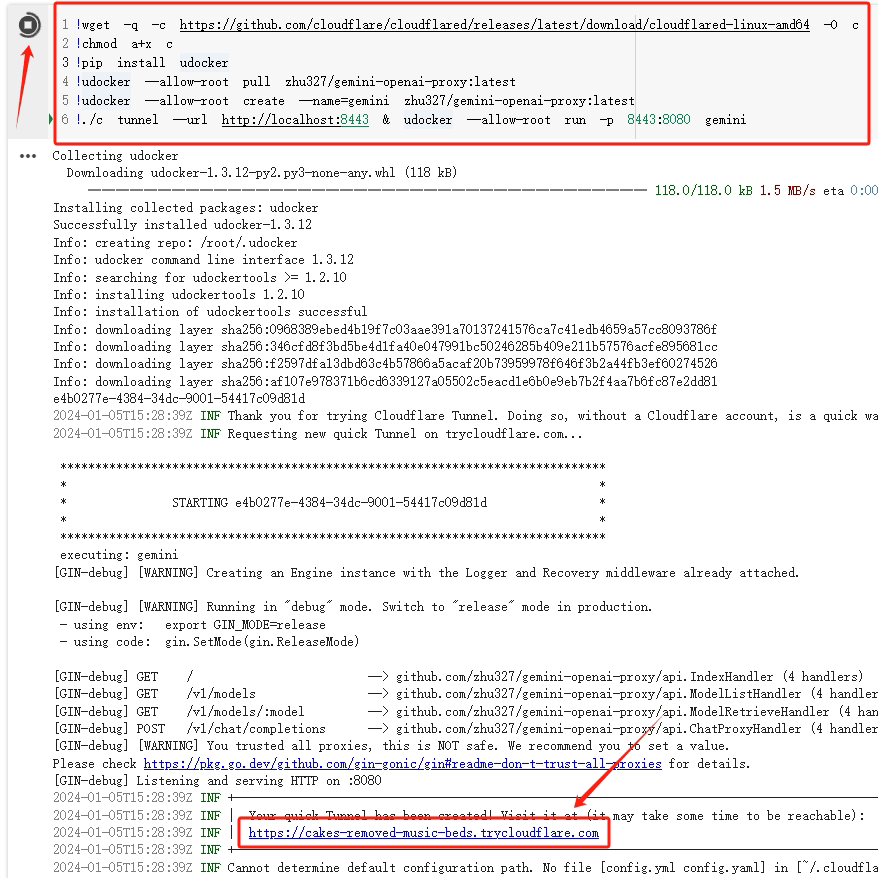

!wget -q -c https://github.com/cloudflare/cloudflared/releases/latest/download/cloudflared-linux-amd64 -O c !chmod a+x c !pip install udocker !udocker --allow-root pull zhu327/gemini-openai-proxy:latest !udocker --allow-root create --name=gemini zhu327/gemini-openai-proxy:latest !./c tunnel --url http://localhost:8443 & udocker --allow-root run -p 8443:8080 gemini

启动,等待 30 秒,获得到接口地址。

示意图:

② 获得 Gemini Pro API Key

从Google Makersuite 申请 Key:点此直达

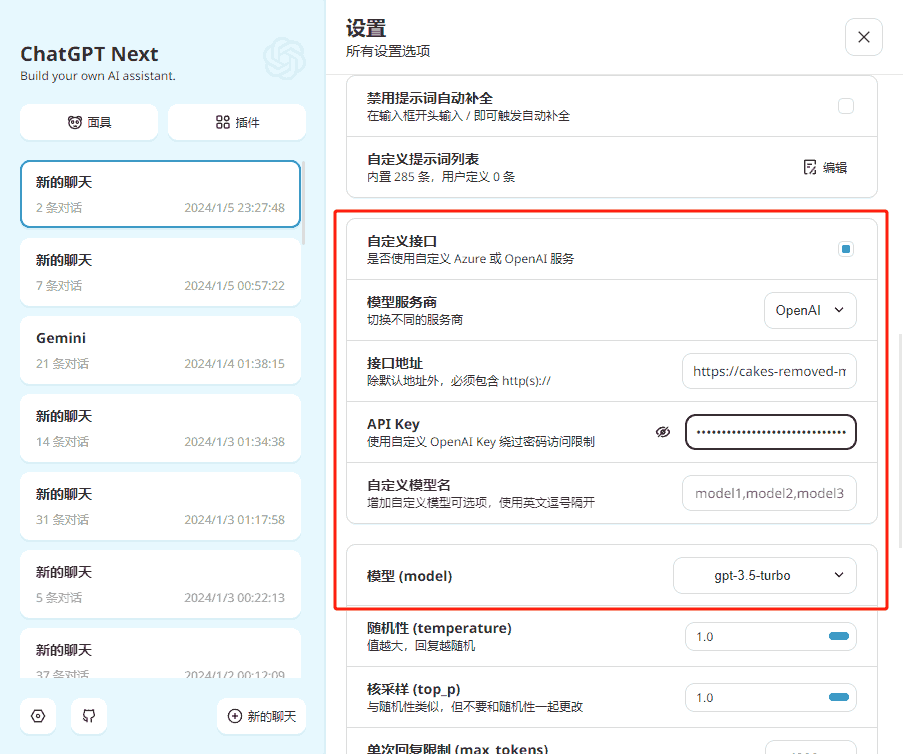

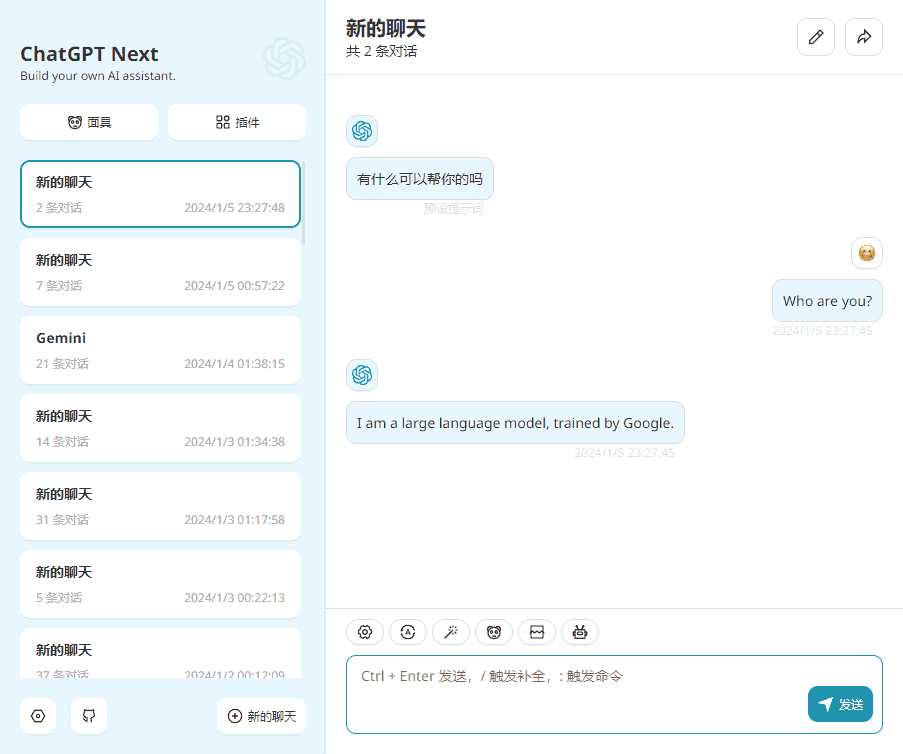

③Demo

④ 一点补充

- gemini-openai-proxy 项目提供了兼容接口

- Colab 不支持安装 Docker,所以用 udocker 作为替代

- Colab 的 8080 端口默认被占用,所以使用 8443

- 为了兼容 Kaggle,cloudflared 需要重命名,否则会引起强制重启

- 随机 url 过于繁琐,最好在 CF 绑定域名

⑤ One more thing

是否支持 NSFW?有限支持。我没有特别写过越狱 prompt,Gemini 并没有拒绝回答。

有其他用户提到模型会拒绝回答,对此,我的经验是伪造 AI 一轮或多轮的回复(当然这需要客户端支持)。